谷歌官方怎么说"抓取预算"?

咱们先听听官方的声音。谷歌在自家博客上提过一嘴:"对于你们SEO圈子里常说的'抓取预算',我们内部其实没有一个完全对应的术语能把它说全。"

谷歌还说了,如果你的新页面通常当天就能被爬虫抓到,那基本不用太操心这个"预算"问题。对于那些总共没几千个页面的小网站,谷歌也觉得一般都能正常抓取,抓取预算这事儿,主要是给那些"家大业大"的网站准备的。

这话听起来好像没毛病,但又不全对。为啥?因为只要你的网站在 Google Search Console 里备了案,那它就一定有个抓取预算,只不过多少的问题。咱们在后台的统计数据里就能清楚看到。

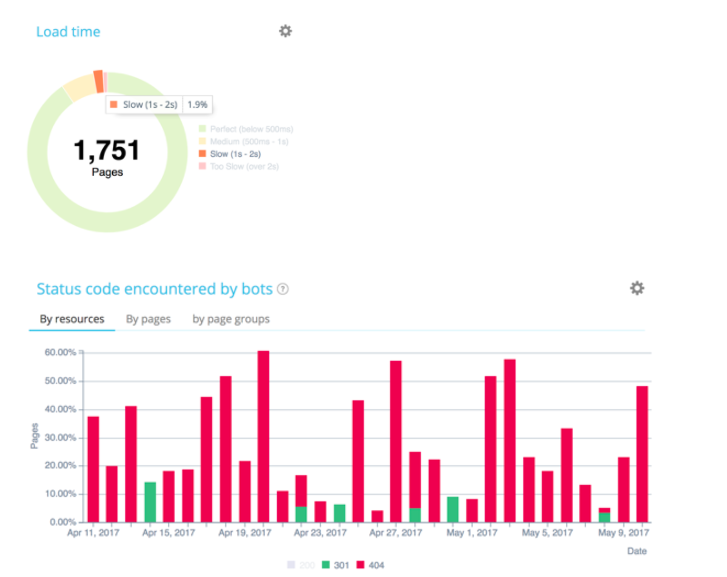

谷歌还在那篇文章里透露,他们搞了个"抓取速率限制"(Crawl Rate Limit),就是给每个网站设定一个抓取速度的上限。打个比方,如果你的网站加载慢得像蜗牛,谷歌蜘蛛可能就直接把给你的"口粮"减半了。这说明啥?影响抓取预算的因素可不少,比如网站架构不行(服务器响应慢、一堆错误代码、内链乱七八糟)、内容质量差或者重复内容太多、设置了蜘蛛陷阱等等,都会让谷歌蜘蛛"不想来"或者"来不了"。

谷歌蜘蛛的"工作流程"和"预算"分配逻辑

想象一下谷歌蜘蛛是怎么干活的:

- 先看"门牌号" (robots.txt): 蜘蛛来访,第一件事是去看

robots.txt文件,搞清楚哪些地方能去,哪些地方是禁区。 - 拿到"任务清单" (URL列表): 然后它会整理出一份需要抓取的URL列表,可能是新发现的链接,也可能是之前抓过需要更新的页面。

- 开始"走街串巷" (抓取URL): 接着,蜘蛛就开始访问这些URL,获取页面内容。同时,它会跟自己数据库里已有的信息做对比,看看是不是新页面,或者内容有没有变化。

- 智能判断,优先"重要路段" (评估页面重要性): 谷歌的目标是尽可能全面、准确地收录有价值的网页。但互联网这么大,蜘蛛的"精力"是有限的,不可能每个页面都天天来。所以,它需要判断哪些页面更"重要"。这个"页面重要性"得分,后面我们会细说,它直接影响蜘蛛多久来一次。

- 特殊情况 (JavaScript 网站): 对于大量使用 JavaScript 的网站,谷歌会派专门的"渲染蜘蛛"来处理。但要注意,这种网站特别耗费资源,蜘蛛来的频率可能很低(比如一个季度才来一次)。如果你的网站是这种情况,得想想办法,怎么让蜘蛛在不执行 JS 的情况下也能发现和抓取核心内容。

说白了,谷歌也得精打细算,优化自己的抓取资源。它会优先把"预算"花在那些它认为更重要的页面上。

为啥谷歌要"精打细算"?影响预算的关键因素

记住,谷歌蜘蛛很忙,时间宝贵。如果你的网站让它"不爽"了,它就会减少给你的"预算"。那么哪些因素是关键呢?

- 网站响应速度 (硬指标): 这是最重要的!网站打开慢,蜘蛛等得不耐烦,抓取效率自然低。尤其现在是移动优先的时代,速度就是生命线。

- 网站"健康状况" (别让蜘蛛总碰壁): 大量的 4xx(找不到页面)、5xx(服务器错误)、过多的 3xx(重定向)都会消耗抓取预算。你想啊,蜘蛛老是碰到死胡同或者绕远路,下次还愿意来吗?它会反复检查这些错误页面是否修复,这都是额外的成本。

- 内容质量 (内容为王,也为预算): 内容要有料、不重复、语义清晰。低质量、重复的内容会让蜘蛛觉得"没意思",不愿意投入更多预算。

- 页面"受欢迎程度" (内链外链都重要): 一个页面获得的内部链接和外部链接越多,尤其是有高权重页面链入,谷歌通常会认为它更重要,分配的预算也会更多。锚文本的多样性也很关键。

- 网站架构和技术细节 (别给蜘蛛添堵): 合理的网站结构、清晰的导航、简洁的代码、优化的图片、正确使用

robots.txt和sitemap.xml等,都能让蜘蛛抓取更顺畅,省时省力。反之,混乱的结构、蜘蛛陷阱(比如无限循环的日历页面)都会浪费预算。

啥是"页面重要性"?它跟 PageRank 不一样

页面重要性 (Page Importance) 跟我们常说的页面排名 (PageRank) 是两个概念,但相互关联。谷歌判断一个页面是否重要,会看这些:

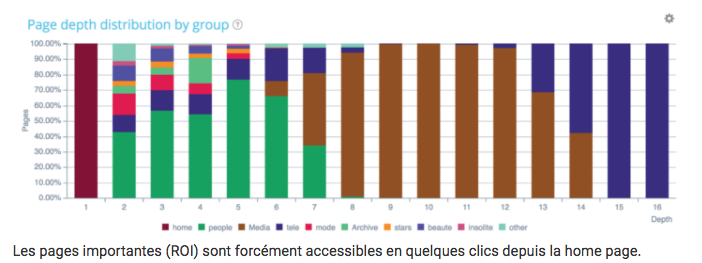

- 页面在网站结构中的位置: 藏得越深的页面(需要点击很多次才能到达),通常被认为越不重要,蜘蛛访问频率越低。

- 页面的 PageRank: Majestic SEO 提出的 TF/CF (Trust Flow/Citation Flow) 指标可以作为参考。页面本身的权重越高,越重要。

- 内部链接得分: 页面获得了多少内部链接,以及这些链接的质量。

- 文档类型: 像 PDF 文件,如果内容优质,有时会被认为更重要,抓取频率可能更高。

- 是否包含在

sitemap.xml中: 明确告诉蜘蛛这个页面需要被抓取。 - 内部链接数量和质量: 指向该页面的内链数量,以及这些链接的锚文本是否相关、有意义。

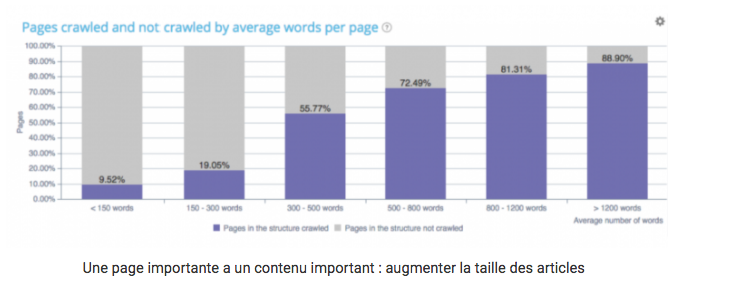

- 内容质量: 字数、内容的独特性(避免相似度过高的页面,否则可能被判为重复内容)。

- 与首页的距离和关系: 首页通常是权重最高的页面,离首页越近的页面可能越重要。

怎么规划,让蜘蛛优先抓取"重点页面"?

URL 调度 (URL Scheduling): 谷歌会根据页面的重要性来决定访问频率。

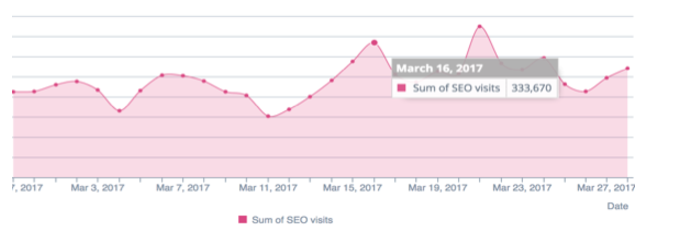

看看上面这个图(同一个网站不同页面的抓取频率),明显能看出谷歌对不同页面组的"关照"程度是不一样的。那些被频繁抓取的页面,排名变动也更快。这启示我们,要想办法提升"重点页面"(比如能带来转化的核心产品页、服务页)的重要性,让蜘蛛更频繁地光顾。

关于抓取预算,你还得知道这些

- Search Console 是你的"仪表盘": 所有在 GSC 里的网站都有抓取数据,多看看没坏处。

- 日志分析是"行车记录仪": 通过分析服务器日志,你能精确追踪谷歌蜘蛛的行为,及时发现抓取异常。很多国内服务器面板或第三方工具都提供这个功能。

- 内部结构是"交通枢纽": 糟糕的内链(比如分页问题、孤岛页面、蜘蛛陷阱)会阻碍蜘蛛找到并抓取你真正想让它抓取的页面。

- 抓取预算直接影响排名: 蜘蛛不来,内容再好也白搭。抓取得越频繁、越充分,页面内容更新被发现和索引的速度就越快,对排名提升越有利。

页面速度:优化抓取预算的"杀手锏"

划重点:页面加载时间是影响抓取预算的最关键因素之一!

在这个移动互联网时代,用户没耐心,蜘蛛也没耐心。网站加载慢,不仅用户体验差,跳出率高,谷歌蜘蛛也会减少分配给你的抓取预算。移动优先索引意味着移动端的加载速度尤为重要。

怎么提速?

- 服务器端优化:

- 选个好主机: 国内访问速度快的服务器是基础。别为了省一点钱选个海外慢机房。

- 减少不必要的重定向: 每次重定向都会增加加载时间和服务器负担。

- 启用 Gzip 压缩: 压缩网页内容,减少传输大小。

- 优化服务器响应时间 (TTFB): 这是服务器处理请求并返回第一个字节所需的时间,越短越好。

- 考虑 CDN: 内容分发网络 (CDN) 能让用户从最近的节点加载资源,显著提升访问速度,对于面向全国或全球用户的网站尤其重要。国内可以选择阿里云、腾讯云等的 CDN 服务。

看看上面 Manageo 这个网站的例子。抓取预算一直挺稳定,线性增长。但到了五月份,每天抓取的页面数突然下降,对应的是网站速度变慢了。谷歌一看,"嘿,这家伙变懒了",直接把预算砍半。想恢复?赶紧优化服务器代码、减少重定向、开启压缩!

- 前端优化:

- 利用浏览器缓存: 让用户的浏览器缓存静态资源(CSS、JS、图片),下次访问就不用重新下载了。

- 优化资源大小: 压缩图片(用 TinyPNG 之类的工具),合并压缩 CSS 和 JS 文件。

- 延迟加载 (Lazy Loading): 图片、视频等非首屏内容,等用户滚动到时再加载。

- 移除阻塞渲染的 JS: 将不影响首屏加载的 JS 脚本放到页面底部,或使用

async/defer属性异步加载。

网站"生病" = 蜘蛛"嫌弃" = 预算减少

定期检查服务器返回给蜘蛛的状态码至关重要。这是谷歌判断你网站技术健康状况的主要方式。

- 盯紧错误代码: 持续监控 4xx 和 5xx 错误,及时修复。

- 关注重定向: 检查是否有过多的 301/302 重定向,特别是重定向链。

- 资源文件也要健康: 确保 CSS、JS、图片等资源文件都能被正常访问(返回 200状态码),不要用

robots.txt屏蔽它们,否则蜘蛛无法完整渲染页面。

保持网站的技术健康,就像保持身体健康一样,能让蜘蛛"心情愉悦",更愿意来访。

内容要"有料"且"独特"

内容质量和抓取预算也有关系。通常,内容越丰富、越独特的页面,被认为越重要。看看上图,谷歌抓取的页面(蓝线)和未抓取的页面(灰线)数量,跟页面上的字数明显相关。

所以,尽量让你的核心页面内容更充实、更有深度,并且保持更新,增加"新鲜度"。

小心规范化标签 (Canonical) 和重复内容

如果两个内容相似的页面没有正确设置 rel="canonical" 标签指向同一个首选 URL,谷歌可能会把它们当成两个不同的页面来抓取,白白浪费一倍的预算。

对于电商网站(比如有很多参数的筛选页面)或接受带参数外部链接的网站来说,规范化标签的管理尤其重要。正确处理近似重复内容和规范化标签,是优化抓取预算的关键一环。

内链结构和"权重"分布

能带来自然搜索流量的页面,通常被认为是"活跃页面"。这些页面理应在网站结构中处于比较靠前的位置。但上图显示,有些活跃页面(能带来流量)却藏在第 15 层那么深!这说明用户可能在搜索这些你以为不重要的内容。你需要把这些页面在网站结构中"提拔"上来,方便用户和蜘蛛找到,从而提升它们的排名。

记住:页面藏得越深,蜘蛛爬得越少!

我的"赚钱页面"位置对吗?

小贴士: 如果你想提升某些页面组的抓取深度(让它们离首页更近),可以考虑创建一个 HTML 站点地图 (HTML Sitemap),把这些重要的页面链接放进去,给蜘蛛提供一个直达通道。

谷歌会对比你的网站结构、它实际抓取的页面以及带来流量的活跃页面。你需要:

- 找出孤岛页面 (Orphan Pages): 这些页面存在于网站上,但没有任何内部链接指向它们。蜘蛛可能还在通过旧链接或 Sitemap 访问它们,但因为没有内链导入权重,它们的重要性很低,这是在浪费预算。如果这些孤岛页面还能带来流量,说明内容有价值,赶紧修复链接结构,把它们重新纳入网站导航体系。

- 链接"失联"的活跃页面: 找出那些能带来流量但没有在主要导航或分类结构中得到足够链接支持的活跃页面,优化内链,提升它们的位置。

及时发现并修复这些链接问题,是优化抓取预算和提升网站整体 SEO 表现的好方法。

常见的抓取预算"杀手"(务必避免)

robots.txt文件返回 404: 这是低级错误,蜘蛛找不到行动指南了。sitemap.xml或 HTML 站点地图过时: 里面包含大量错误链接或未及时更新,误导蜘蛛。- 大量的 5xx / 4xx / 软 404 错误: 前面说过了,严重影响蜘蛛体验。

- 存在重定向链: 比如 A→B→C,增加抓取负担。

- 错误的规范化标签 (Canonical): 导致预算浪费在重复内容上。

- 大量重复或近似重复内容: 包括页脚、侧边栏的模板化内容,以及 HTTP 和 HTTPS 版本未处理好等。

- 服务器响应时间过长 (TTFB 高): 硬伤。

- 页面体积过大: 图片、代码未优化,加载缓慢。

- AMP 页面错误 (如果使用): 确保 AMP 配置正确。虽然 AMP 主要用于新闻媒体,但谷歌有时也会在其他类型网站(如电商)的结果中展示 AMP 页面。

- 糟糕的内部链接结构: 使用

nofollow阻止权重传递到重要页面,或者内链混乱。 - 过度依赖 JS 而无替代方案: 对于核心内容和导航,如果完全依赖 JS 渲染而没有提供 HTML 替代(例如通过服务器端渲染 SSR 或预渲染 Prerendering),蜘蛛可能无法抓取。

总结:优化抓取预算,你需要这么做

想让谷歌蜘蛛更"勤奋"地光顾你的网站,并优先抓取你的核心页面?记住以下几点:

- 了解你的"家底": 明确哪些是你的核心页面(能带来流量和转化的页面),并通过 GSC 和日志分析了解谷歌蜘蛛当前的抓取行为。

- 速度!速度!速度!: 全方位提升页面加载速度,这是重中之重。

- 优化内部链接: 把核心页面放在更容易被发现的位置(靠近首页),确保内链结构清晰合理,权重能顺畅传递。

- 消灭孤岛页面: 修复没有内链指向的有价值页面。

- 丰富核心页面内容: 提升内容的质量和独特性。

- 保持内容新鲜度: 定期更新核心页面。

- 清理低质量和重复内容: 别让垃圾内容拖后腿。

- 保持网站技术健康: 避免各种技术错误。

做好这些,你的抓取预算自然会得到优化,网站的 SEO 表现也会更上一层楼!